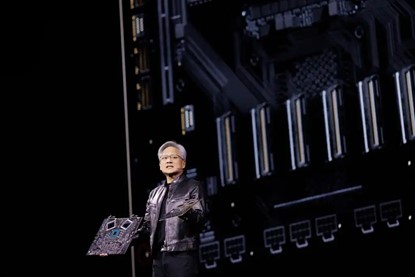

英伟达GTC 2024总结:除了Blackwell外,还有NIM微服务、高速网络和OVX等

英伟达GTC 2024总结:除了Blackwell外,还有NIM微服务、高速网络和OVX等

作者:开源爱好者

来源:

|

英伟达GDC大会已落幕,除了Blackwell架构和强大的新DGX系统的重大发布外,还有许多其他新闻值得关注。以下是一些你可能错过的新闻概览: 高速网络平台 英伟达既是一家GPU公司,也是一家网络公司,尽管其并未将太多精力放在网络方面。但英伟达与Mellanox联手取得了不小的进展。该公司宣布了两款新的高速网络平台,吞吐量速度高达800 GB/s,专为AI系统打造。

第一个平台是Quantum-X800 InfiniBand,由Quantum 3400交换机和ConnectX-8 SuperNIC两部分组成。与前一代产品相比,其带宽容量提高了5倍,网络内计算能力提高了9倍,总吞吐量达到14.4 teraflops。 第二个平台是Spectrum-X800 Ethernet,采用了Spectrum SN5600 800Gbps交换机和Nvidia BlueField-3 SuperNIC。该平台专为多租户生成式AI云和大型企业设计。 包括Microsoft Azure、Oracle Cloud Infrastructure和Coreweave在内的云服务提供商都在排队等待Quantum InfiniBand和Spectrum-X Ethernet的发货。 推理微服务 微服务通常与AI没有直接关联,因为它们是小而轻量的程序,仅用于执行单一或少量功能。它们在计算方面较为节俭,与AI形成鲜明对比。然而,英伟达却推出了用于大型语言模型(LLMs)推理的微服务。 这款名为Nvidia Inference Microservices(NIM)的软件是Nvidia企业AI软件包的一部分。它包含一套优化的推理引擎、行业标准API以及对AI模型的支持,所有这些都打包在容器中,便于部署。NIM不仅提供预构建的模型,还允许组织添加自己的专有数据和模型。 谈到这款NIM技术,可以说Nvidia并非孤军奋战。该公司与众多主流软件供应商合作,包括SAP、Adobe、Cadence、CrowdStrike和ServiceNow,同时还与数据平台供应商如Box、Cohesity、Cloudera、Databricks、Datastax和NetApp展开合作。 NIM微服务支持来自Google、Meta、Hugging Face、Microsoft、Mistral AI和Stability AI等众多流行AI模型的推理处理。NIM微服务将可通过亚马逊网络服务、Google Kubernetes Engine和Microsoft Azure AI获取。 进军存储验证领域 存储是AI处理的关键组成部分,因为没有大量数据,AI就无从谈起。为此,Nvidia启动了一项存储合作伙伴验证计划,旨在通过为AI和图形密集型工作负载提供认证,帮助企业找到合适的存储解决方案。该计划名为Nvidia OVX,命名方案与DGX计算服务器类似。首批寻求OVX存储验证的公司包括DDN、Dell PowerScale、NetApp、Pure Storage和WEKA。 NVIDIA OVX服务器将高性能、GPU加速的计算能力与高速存储访问和低延迟网络相结合,以应对一系列复杂的AI和图形密集型工作负载。该计划为合作伙伴提供了一个标准化的过程来验证其存储设备。 服务器制造商纷纷采用Blackwell 所有主要的原始设备制造商都宣布了基于Blackwell的新产品。 戴尔科技宣布,PowerEdge XE9680服务器——其旗舰八路GPU加速服务器,用于生成式AI训练、模型定制和大规模AI推理——将更新为新一代Blackwell。 联想宣布推出新款8-GPU AI服务器——ThinkSystem SR680a V3、SR685a V3和SR780a V3 GPU系统——使用Blackwell支持AI、高性能计算(HPC)以及各行业的图形和仿真工作负载。 HPC宣布,去年11月在SC23上公布的超级计算产品现已可供寻求为大型AI模型的开发和训练配置预制和预测试的全栈解决方案的组织订购。这些服务器是专为帮助客户加速生成式AI和深度学习项目而量身定制的一站式解决方案,可支持最多168个GH200 Grace Hopper超级芯片。除了硬件之外,HPE服务还为企业提供设计、部署和管理解决方案的协助。 在GTC 2024上,超微发布了一系列服务器,其中新系统采用了GB200 Grace Blackwell超级芯片以及B200和B100 GPU。此外,该公司表示,其现有的Nvidia HGX H100和H200系统已为新型GPU做好准备,将“即插即用”,这意味着客户可以在Blackwell可用时将其基于Hopper的硬件替换为Blackwell。超微称,它将是今年晚些时候首个推出HGX B200 8-GPU和HGX B100 8-GPU系统的服务器公司。 Nvidia与AWS超级计算机迎来Blackwell升级 去年,Nvidia与亚马逊联手打造了一台将成为全球最快的超级计算机,名为Ceiba项目。随着Blackwell处理器的发布,Ceiba项目将获得升级,使其速度比原计划提高多达6倍。 Ceiba项目最初被描述为绝对的巨无霸,配备了超过1.6万个H100 Hopper AI处理器,并在完成后提供65 exaflops的AI处理能力。相比之下,目前最快的超级计算机是美国能源部的Frontier,其处理能力可达到1.1 exaflops。 Nvidia和亚马逊计划使用10386个Blackwell B200超级芯片对Ceiba项目进行升级。B200由一个Grace CPU和两个缝合在一起的Blackwell芯片组成,这意味着总共有20736个GPU,Nvidia声称这台机器可以达到惊人的414 exaflops。 |

商情

商情