千瓦级芯片时代来临,液冷势在必行

千瓦级芯片时代来临,液冷势在必行

作者:航标

来源:航标IT精选

|

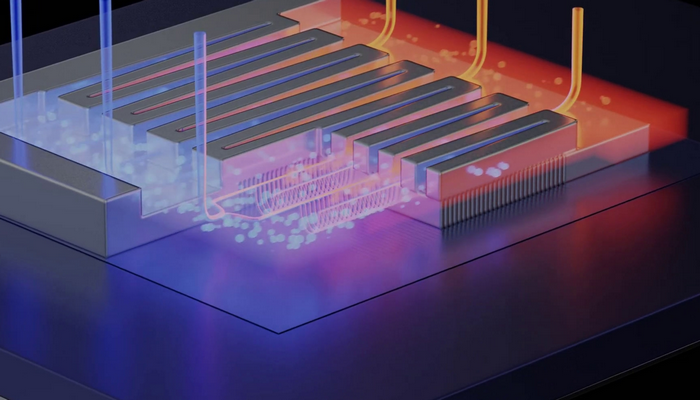

英伟达在日前举行的GTC大会上发布了新一代Blackwell 架构GPU。作为Hopper架构的后继者,Blackwell在性能提升方面表现出色,其最高规格的Blackwell芯片浮点运算速度(FLOPS)大约快了5倍。当然,其功耗也达到了新高,GB200功耗超过了1200W。

随着性能的提升GPU的功耗一直在增长。当前英伟达旗舰 H100 GPU 的整体功耗为700W,英伟达H200和AMD Instinct MI300X 的整体功耗在 700W~750W。随着性能的不断提升,GPU还将继续提升。未来千瓦级芯片肯定会越来越普及,这就给服务器致冷提出了新的挑战。 服务器功耗越大,传统风冷遇到了问题,从而带动液冷市场迅速增长。根据IDC发布的《中国半年度液冷服务器市场(2023上半年)跟踪》报告,2023上半年中国液冷服务器市场规模达到6.6亿美元,同比增长283.3%,预计2023年全年将达到15.1亿美元。IDC预计,2022-2027年,中国液冷服务器市场年复合增长率将达到54.7%,2027年市场规模将达到89亿美元。 AI服务器成为“电老虎” 随着生成式AI技术取得突破,越来越多的公司选择部署AI大模型来进行训练和推理,这些大模型动辄成百上千GPU卡,有些甚至多大数十万张,它们在给人类社会带来巨大变革的同时,使得这些大模型也成为能源消耗大户,人工智能应用正在成为新的“电老虎”。 全球数据中心标准组织之Uptime估计,英伟达单在2023年一年就售出了60万张H100(功耗700w)。预计到2024年底,这家芯片制造巨头的GPU出货量有望进一步增长至150万至200万张。驱动这些芯片工作的用电量自然不是个小数字。 实际上,生成式AI带来的种种创新都是以处理性能和功耗方面的高昂成本为代价。有媒体报道,引爆全球人工智能产业浪潮的ChatGPT,每天的耗电量已超过50万千瓦时来响应2亿个访问请求,相当于1.7万个普通美国家庭的用电量总合。同样,Google搜索所消耗的电力相当于一个爱尔兰国家的电力消耗。 根据UPtime的预测,到2025年,人工智能业务在全球数据中心用电量中的占比将从2%猛增到10%。马斯克曾预测,未来两年内人工智能行业将由“缺硅”变为“缺电”,而这可能阻碍人工智能的发展。在他看来,电力短缺可能会造成严重后果,就像芯片短缺一度阻碍科技和汽车行业一样。 不得不选的液冷 生成式AI热直接带动了AI服务器的普及。AI服务器是以GPU为主要算力的服务器,一台AI服务器可能有6-8张GPU卡。如果一张GPU卡功耗达到1000kw的话,一台AI服务器很容易就能突破10kw,这不仅挑战服务器的致冷能力,也对部署服务器的机架以及整个数据中心的致冷能力提出了挑战。因为在传统数据中心,如果采用风冷普通机架设计功率为10-15KW,最高也不会超过20KW,根本无法支持如此高功率的服务器。 一般来说,IT设备越耗电,产生的热量越大,致冷的用电量就越多,最后数据中心的整体用电量也就越高。据统计,在采用风冷的传统数据中心,致冷电力消耗大约占整个数据中心用电的1/3,其PUE(PUE是一种表示用电效率的指标,越低表示直接用于生产的电越多,效率就越好)值一般在1.5以上。 2021年7月,工业和信息化部印发了《新型数据中心发展三年行动计划(2021-2023年)》,提出到2023年底,新建大型及以上数据中心PUE降低到1.3以下,严寒和寒冷地区力争降低到1.25以下。 数据中心过高的用电量已经拉响了警报。电力在不少城市都是非常紧缺的,同时国家也在大力推动节能环保,一直在限制高能耗数据中心的建设。比如,北京要求新建数据中心PUE值1.4,上海、深圳要求1.3。高PUE值意味着高能耗,特别是对于一些大型和超大型数据中心,其用电量大,寻找更好的节能技术既是国产政策的要求,也有降低运营成本的考虑。 液冷技术就在这种背景下得到逐步推广。液冷通过特殊的液体来实现热交互,并把热带出数据中心,其效率要远远高于风冷。液冷技术可以让PUE值达到1.1,甚至接近于1,也就是说几乎没有致冷方面的消耗。 更高效的制冷还有助于提高设备高可靠性,比如,取消风扇后没有了震动可以提升设备可靠性。有研究数据显示,液冷技术让设备故障率下降了50%。另外,液冷的机柜具有更高的功率密度意味着能容纳更多的设备,同时又少了空调,因此相比传统风冷数据中心空间也要更节约。 浸没式液冷与冷板液冷,哪种适合你? 液冷其实由来已久,在HPC行业早就已经应用。液冷主要分为冷板式液冷和浸没式液冷两大类型。冷板式液冷技术的液体不与电子器件直接接触,而是通过高效热传导部件将被热量传递到冷媒中,因此冷板式液冷技术又称为间接液冷技术。 目前冷板液冷也有2种形式,一种仅仅将CPU和内存的热量带走,其热量通过部署在机架内部的CDU释放,整个机房的致冷还是通过空调来解决,好处是不用进行机房改造,但只能解决局部热点问题。另外一种是将热量带到机房外,在室外完成热量交互,这种方式有更高的致冷效率,单改造成本也较高。 浸没式液冷技术相对冷板式液冷更激进一些,它将服务器主板、CPU、内存等发热量大的元器件完全浸没在特殊液体中,各发热部件产生的热量引起液体温度上升,当温度升高到系统压力所对应的沸点,从液态变化为气态,通过汽化热吸收热量实现热量的转移,这种通过冷媒吸收热量冷却的技术即相变液冷技术。 浸没式液冷利用液体相变将热量直接带走,和冷板式液冷相比,效率更高,是一个更节能、更高效的致冷模式,能让单机柜功率密度提升3倍。但其前期投资相对冷板式液冷大,而且技术成熟度也不如冷板式液冷。据统计,目前市场冷板式液冷已经占据90%以上。 尽管如此,从能效和空间利用率与可循环等来开,浸没式液冷作为一种高效节能、绿色环保的技术还是被广泛看好。 近年来,越来越多的主流IT设备厂商均已公开表明将加大研发力度并加快液冷产品迭代速度,液冷技术在中国普及得很快,很多服务器厂商也有液冷解决方案,比如中科曙光、宁畅、浪潮等都有液冷服务器和液冷机柜,单大多以冷板式为主。英伟达就已经宣布下一代DGX系统采用液冷。一些互联网大厂也在探索,尤其是一些云服务商。比如,2018年阿里巴巴在其张北数据中心部署了全球首个浸没式液冷服务器集群,将这项技术真正带到了生产环境。微软、Google还曾经探索过海底数据中心,不过目前距离实用还有些距离。 总之,我国拥有众多超大型的数据中心,在AI应用的推动下,对液冷有着很大的需求,未来中国液冷服务器市场有望持续保持高速增长。 |

商情

商情